1.安装 ollama

ollama 是一个可以便捷下载和在本地运行 llm 模型的工具

第一步:从官网下载 ollama:https://ollama.com/

完成后根据提示安装,可根据引导下载你的第一个模型,点击 finish 自动运行终端即可使用

下载需要的模型

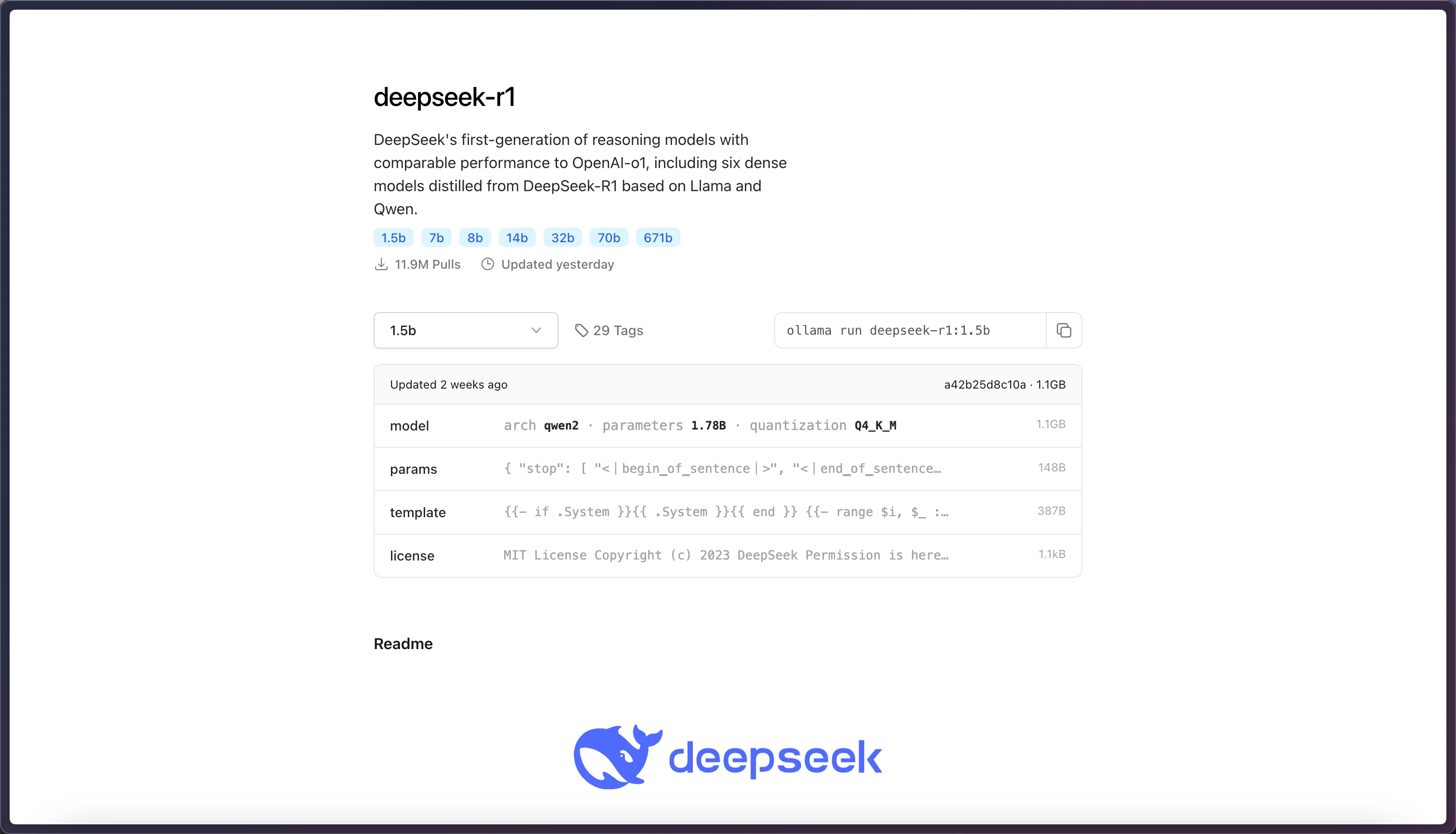

从官网的 Model 中寻找需要使用的模型,注意根据机器配置选择参数量大小合适的模型。这里以 deepseek-r1:1.5b 为例

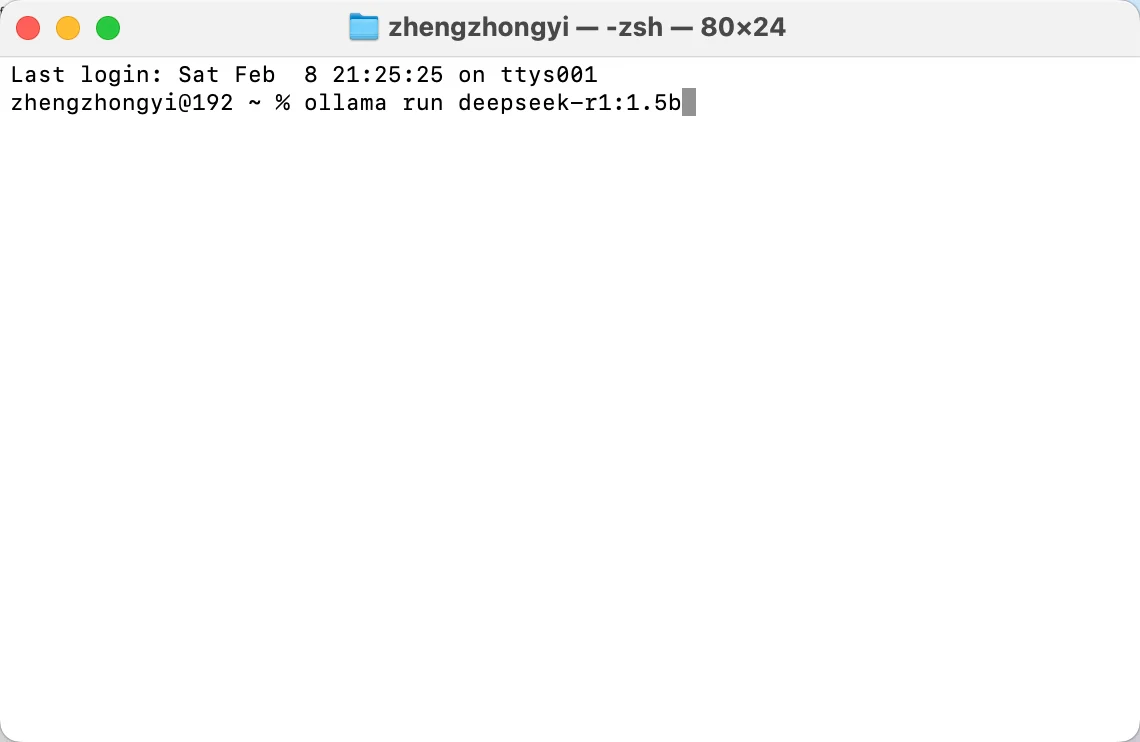

打开终端,运行

ollama run deepseek-r1:1.5b进行下载

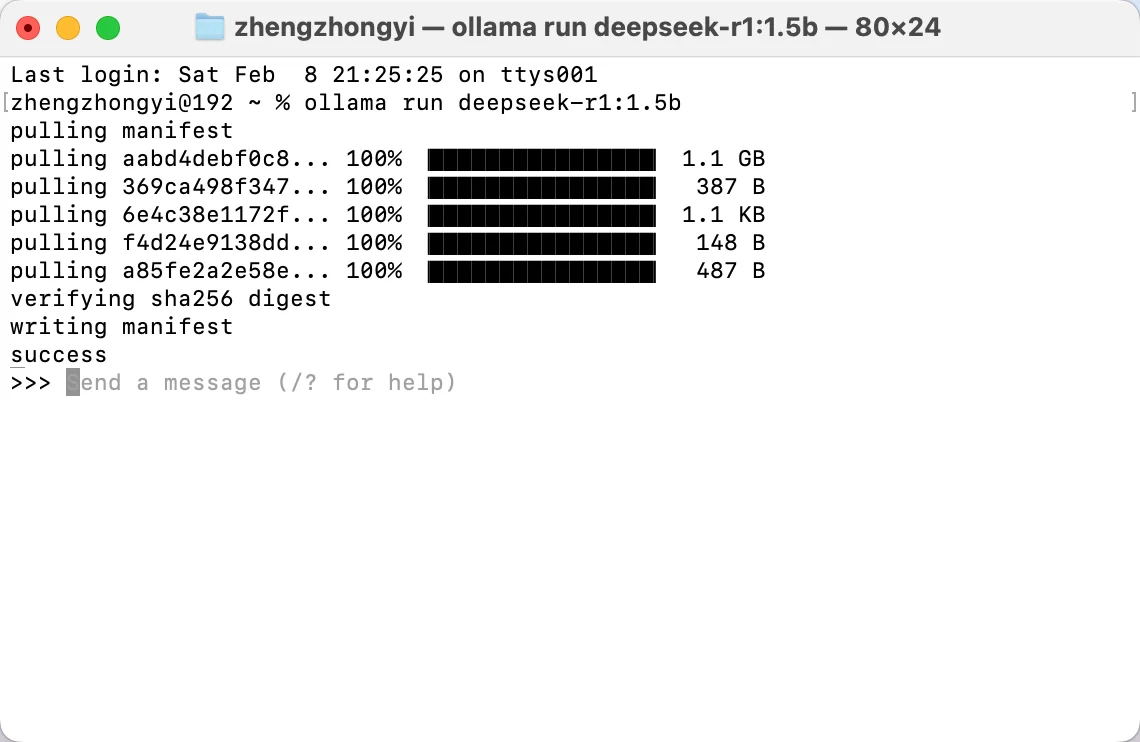

如下显示模型下载完成

2.安装 open-webui

open-webui 是目前 github 上点赞数最高的 LLM 对话 webui 项目(star 数70.3k),且在持续更新中,安装相对简单(但相比于下载即用的客户端应用有一定的门槛)。

安装准备

安装和运行 open-webui 前需要先具备:

python3.11 (需要安装 python 指定版本)

pip (用于下载 open-webui包)

因此你可能需要了解 python 的安装和创建及使用虚拟环境的方式,使用虚拟环境来避免依赖错误安装导致的奇怪问题,以及尽量使用科学上网,可以省很多事。

安装 Open WebUI: 打开终端运行安装命令

pip install open-webui运行 Open WebUI: 安装完成后,通过下面的命令来运行

open-webui serve这会启动 open webui 服务,访问 http://localhost:8080 来使用

官方的项目下方对这些步骤有完整说明,如果遇到问题可以参考更为完整的文档:https://docs.openwebui.com/getting-started/quick-start

如果你使用 macOS 系统,推荐使用 homebrew 来安装 python, 按照我下面的流程:

安装 homebrew

前往https://github.com/Homebrew/brew/releases 下载最新发行版的 pkg 安装包

Homebrew-x.x.xx你可能需要运行

brew --version来验证是否安装成功通过 brew 安装 python

brew install python@3.11安装完 Python 3.11 后,创建一个新的虚拟环境,指定使用 Python 3.11:

python3.11 -m venv myenv激活虚拟环境

source myenv/bin/activate安装 open-webui

pip install open-webui

3.运行 Open WebUI 并加载模型

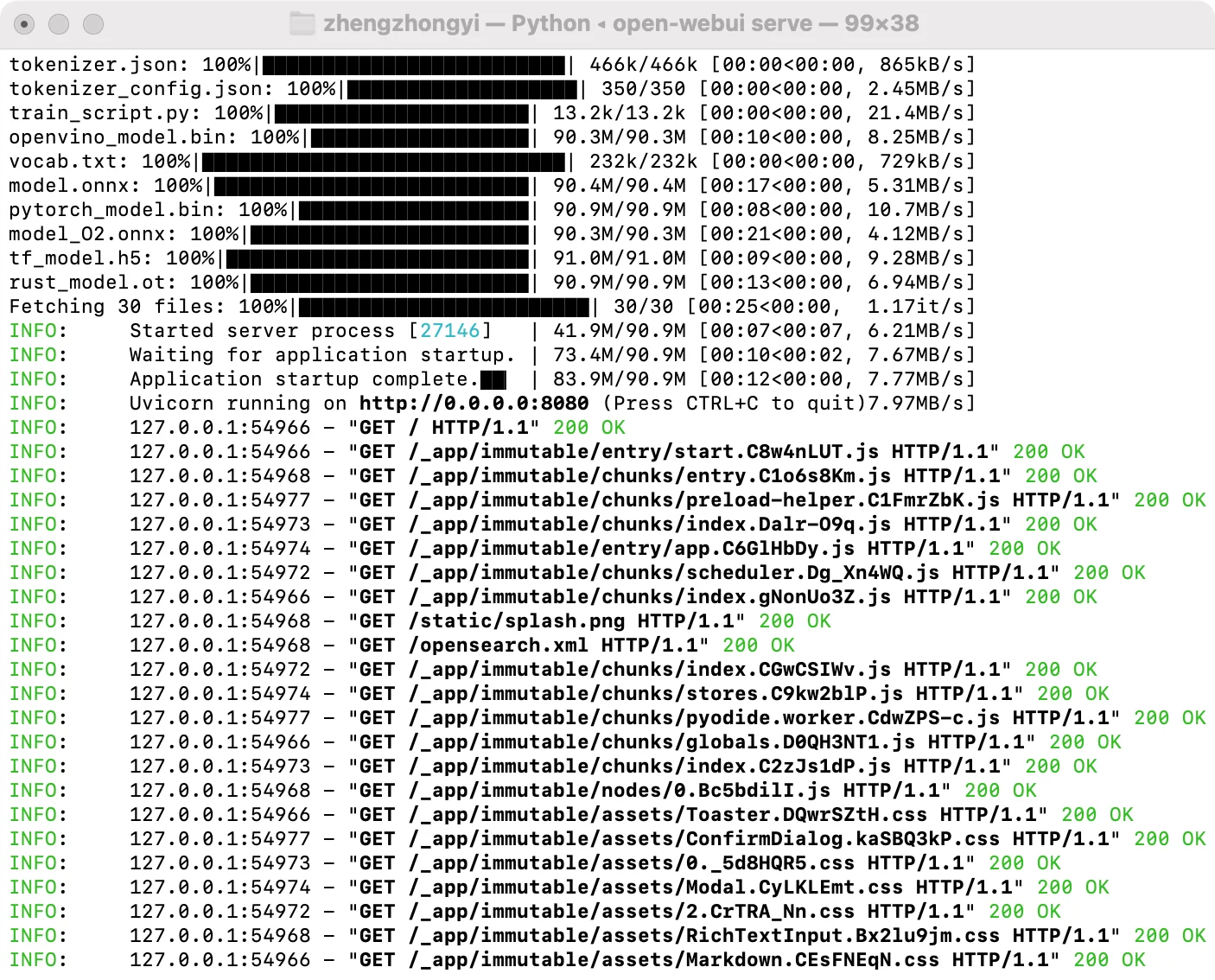

安装完成后执行open-webui serve

看到类似下面的输出表示运行成功

打开浏览器访问 http://localhost:8080

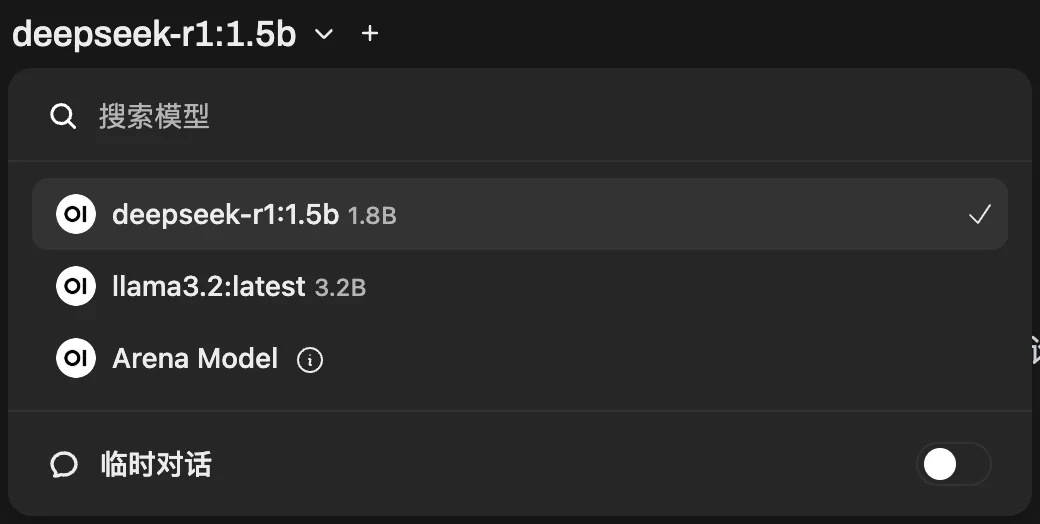

左上角可以选择切换模型

关于模型参数选择,这里有一张 macbook 配置参考

图片来源:小红书博主 line8(小红书号:11511025562)

这里还有一篇使用 docker 部署的文章:https://www.cnblogs.com/aeolian/p/18699187